来源:微信公众号“机器之心”porn 动漫

深度学习掀翻海啸

如今,深度学习海潮拍打计较机语言的海岸已有好几年,可是,2015年似乎才是这场海啸全力冲击天然语言处理(NLP)会议的一年。——Dr. Christopher D. Manning, Dec 2015

通盘研究畛域的训练设施曾经赶快被新发现超越,这句话听起来有些张大其辞,就像是说它被「海啸」蹙迫了一样。可是,这种灾荒性的形容的确不错用来神志深度学习在往常几年中的异军突起——显赫改善东说念主们对责罚东说念主工智能最难问题设施的独霸智商,诱导工业巨东说念主(比如谷歌等)的多数投资,研究论文的指数式增长(以及机器学习的研究生生源高涨)。在听了数节机器学习课堂,甚而在本科研究中使用它以后,我不禁好奇:这个新的「深度学习」会不会是一个幻想,抑或上世纪80年代曾经研发出来的「东说念主工智能神经麇集」扩大版?让我告诉你,一言难尽——这不单是是一个商量神经麇集的故事,也不单是是一个商量一系列研究突破的故事,这些突破让深度学习变得比「大型神经麇集」愈加真义,而是一个商量几位不打消的研究员若何熬过黢黑数十年,直至挽救神经麇集,收场深度学习空想的故事。

机器学习算法的百年历史

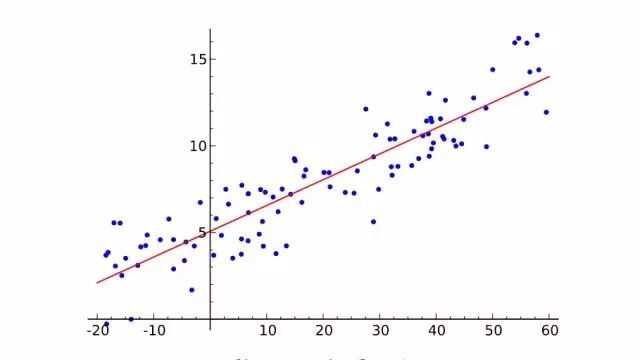

线性回来

国产视频偷拍自拍在线最初不祥先容一下机器学习是什么。从二维图像上取一些点,尽可能绘出一条拟合这些点的直线。你刚才作念的即是从几对输入值(x)和输出值(y)的实例中概述出一个一般函数,任何输入值都会有一个对应的输出值。这叫作念线性回来,一个有着两百年历史从一些输入输出对组中推断出一般函数的技巧。这即是它很棒的原因:好多函数难以给出明确的方程抒发,可是,却很容易在现实世界征集到输入和输出值实例——比如,将说出来的词的音频算作输入,词自己算作输出的映射函数。

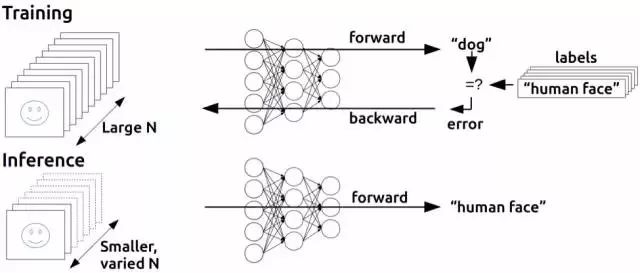

线性回来对于责罚语音识别这个问题来说有点太无须,可是,它所作念的基本上即是监督式机器学习:给定考验样本,「学习」一个函数,每一个样本数据即是需要学习的函数的输入输出数据(无监督学习,稍后在再叙)。尤其是,机器学习应该推导出一个函数,它能够很好地泛化到不在考验蚁集的输入值上,既然咱们真的能将它哄骗到尚未有输出的输入中。举例,谷歌的语音识别技巧由领有多数考验集的机器学习驱动,可是,它的考验集也不可能大到包含你手机通盘语音输入。

泛化智商机制如斯重要,以至于总会有一套测试数据组(更多的输入值与输出值样本)这套数据组并不包括在考验组当中。通过不雅察有若干个正确计较出输入值所对应的输出值的样本,这套单独数据组不错用来估测机器学习技巧有用性。概述化的克星是过度拟合——学习一个对于考验集有用可是却在测试数据组中表现很差的函数。既然机器学习研究者们需要用来比较设施有用性的技能,跟着时候的推移,尺度考验数据组以及测试组可被用来评估机器学习算法。

好了,界说谈得满盈多了。重心是——咱们绘画线条的商量只是一个特别不祥的监督机器学习例子:要点在于考验集(X为输入,Y为输出),线条是近似函数,用这条线来为任何莫得包含在考验集数据里的X值(输入值)找到相应的Y值(输出值)。别悲悼,接下来的历史就不会这样干巴巴了。让咱们接续吧。

作假答允的乖张

显然这里话题是神经麇集,那咱们媒介里为何要扯线性回来呢?呃, 事实上线性回来和机器学习一开首的设施构想,弗兰克· 罗森布拉特(Frank Rosenblatt)的感知机, 有些许相似性。

Perceptron

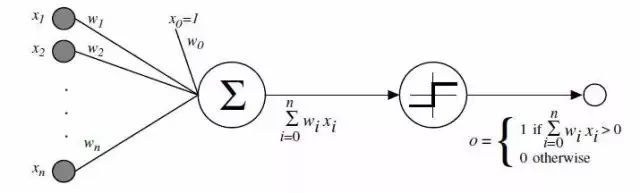

心理学家Rosenblatt构想了感知机,它算作简化的数学模子解释大脑神经元若何职责:它取一组二进制输入值(隔邻的神经元),将每个输入值乘以一个一语气值权重(每个隔邻神经元的突触强度),并拓荒一个阈值,如果这些加权输入值的和越过这个阈值,就输出1,不然输出0(同理于神经元是否放电)。对于感知机,绝大多数输入值不是一些数据,即是别的感知机的输出值。但有一个额外的细节:这些感知机有一个特殊的,输入值为1的,「偏置」输入,因为咱们能赔偿加权和,它基本上确保了更多的函数在同样的输入值下是可计较的。这一对于神经元的模子是建立在沃伦·麦卡洛克(Warren McCulloch)和沃尔特·皮兹(Walter Pitts)职责上的。他们曾标明,把二进制输入值加起来,并在和大于一个阈值时输出1,不然输出0的神经元模子,不错模拟基本的或/与/非逻辑函数。这在东说念主工智能的早期期间可不得了——其时的主流念念想是,计较机能够作念隆重的逻辑推理将本色上责罚东说念主工智能问题。

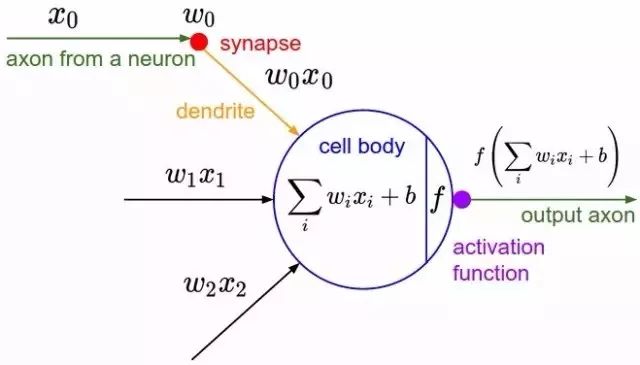

另一个图表,自满诞生物学上的灵感。激活函数即是东说念主们刻下说的非线性函数,它作用于输入值的加权和以产生东说念主工神经元的输出值——在罗森布拉特的感知机情况下,这个函数即是输出一个阈值操作

关联词,麦卡洛克-皮兹模子贫窭一个对AI而言至关重要的学习机制。这即是感知机更出色的场合所在——罗森布拉特受到唐纳德·赫布(Donald Hebb) 基础性职责的启发,想出一个让这种东说念主工神经元学习的办法。赫布提议了一个出东说念主预想并影响深刻的想法,称常识和学习发生在大脑主淌若通过神经元间突触的形成与变化,简要表述为赫布律例:

当细胞A的轴突足以接近以引发细胞B,并反复持续地对细胞B放电,一些滋长流程或代谢变化将发生在某一个或这两个细胞内,以致A算作对B放电的细胞中的一个,效率加多。

感知机并莫得王人备罢免这个想法,但通过调输入值的权重,不错有一个特别不祥直不雅的学习决策:给定一个有输入输出实例的考验集,感知机应该「学习」一个函数:对每个例子,若感知机的输出值比实例低太多,则加多它的权重,不然若设比实例高太多,则减少它的权重。更隆重少量儿的该算法如下:

从感知机有随机的权重和一个考验集开首。

对于考验蚁集一个实例的输入值,计较感知机的输出值。

如若感知机的输出值和实例中默许正确的输出值不同:(1)若输出值应该为0但实践为1,减少输入值是1的例子的权重。(2)若输出值应该为1但实践为0,加多输入值是1的例子的权重。

对于考验蚁集下一个例子作念同样的事,重叠法子2-4直到感知机不再出错。

这个流程很不祥,产生了一个不祥的闭幕:一个输入线性函数(加权和),正如线性回来被非线性激活函数「压扁」了一样(对带权重乞降设定阈值的举止)。当函数的输出值是一个有限集时(举例逻辑函数,它只须两个输出值True/1 和 False/0),给带权重的和缔造阈值是没问题的,是以问题实践上不在于要对任何输入数据集生成一个数值上一语气的输出(即回来类问题),而在于对输入数据作念好合适的标签(分类问题)。

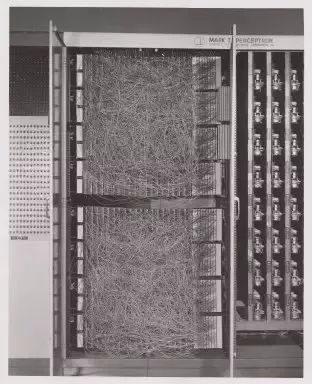

康奈尔航天实验室的Mark I 感知机,第一台感知机的硬件

罗森布拉特用定制硬件的设施收场了感知机的想法(在花哨的编程语言被广泛使用之前),展示出它不错用来学习对20×20像素输入中的不祥局面进行正确分类。自此,机器学习问世了——建造了一台不错从已知的输入输出对中得出近似函数的计较机。在这个例子中,它只学习了一个小玩物般的函数,可是从中不难假想出有用的应用,举例将东说念主类乱糟糟的手写字调换为机器可读的文本。

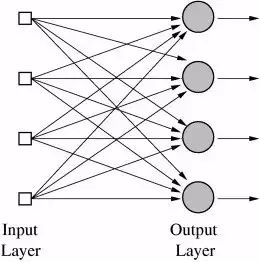

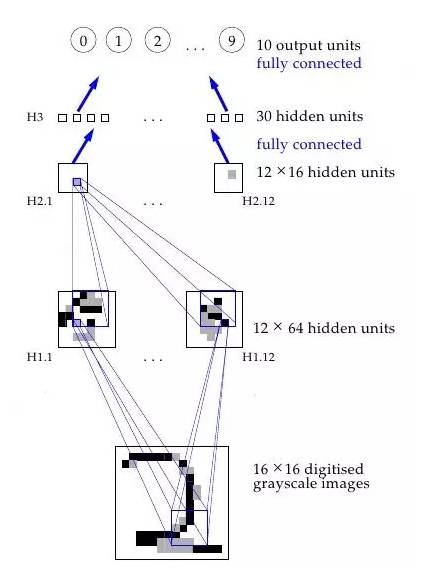

很重要的是,这种设施还不错用在多个输出值的函数中,或具有多个类别的分类任务。这对一台感知机来说是不可能完成的,因为它只须一个输出,可是,多输出函数能用位于团结层的多个感知机来学习,每个感知机接收到团结个输入,但辨别负责函数的不同输出。实践上,神经麇集(准确的说应该是「东说念主工神经麇集(ANN,Artificial Neural Networks)」)即是多层感知机(今天感知机每每被称为神经元)辛劳,只不外在这个阶段,只须一层——输出层。是以,神经麇集的典型应用例子即是分辨手写数字。输入是图像的像素,有10个输出神经元,每一个辨别对应着10个可能的数字。在这个案例中,10个神经元中,只须1个输出1,权值最高的和被看作念是正确的输出,而其他的则输出0。

多层输出的神经麇集

也不错假想一个与感知机不同的东说念主工神经麇集。举例,阈值激活函数并不是必要的; 1960年,Bernard Widrow和Tedd Hoff很快开首探索一种设施——领受适合性的「自适合(ADALINE)」神经元来输出权值的输入,这种神经元使用化学「 存储电阻器」,并展示了这种「自适合线性神经元」能够在电路中成为「 存储电阻器」的一部分(存储电阻器是带有存储的电阻)。他们还展示了,不消阈值激活函数,在数学上很好意思,因为神经元的学习机制是基于将失误最小化的微积分,而微积分咱们都很老成了。

如果咱们多念念考一下 「自适合(ADALINE)」,就会有进一步的洞见:为多数输入找到一组权重真的只是一种线性回来。再一次,就像用线性回来一样,这也不及以责罚诸如语音识别或计较机视觉这样的东说念主工智能难题。McCullough,Pitts和罗森布拉特真实感到兴盛的是联结主义(Connectionism)这个往常的想法:如斯不祥计较机单元组成的麇集,其功能会大好多而且不错责罚东说念主工智能难题。而且罗森布拉特说的和(直率说很好笑的)《纽约时报》这段引文的道理差未几:

舟师流露了一台尚处初期的电子计较机,期待这台电子计较机能行走,话语,看和写,我方复制出自身存介怀志…罗森布拉特博士,康奈尔航空实验室的一位心理学家说,感知机能算作机械天际探险者被辐射到行星上。

这种话语无疑会触怒东说念主工畛域的其他研究东说念主员,其中有许多研究东说念主员都在专注于这样的研究设施,它们以带有具体章程(这些章程罢免逻辑数学律例)的标记操算作基础。MIT东说念主工智能实验室创始东说念主Marvin Minsky和Seymour Paper即是对这一炒作持怀疑格调研究东说念主员中的两位,1969年,他们在一册首创性著述中抒发了这种质疑,书中严谨分析了感知机的局限性,书名很贴切,叫《感知机》。

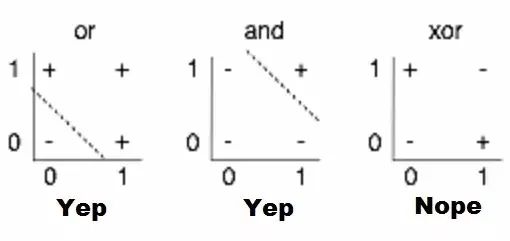

他们分析中,最被广为估量的内容即是对感知机放胆的证据,举例,他们不可学习不祥的布尔函数XOR,因为它不可进行线性分离。天然此处历史无极,可是,东说念主们普遍以为这本书对东说念主工智能步入第一个冬天起到了引风吹火的作用——大肆炒作之后,东说念主工智能插足泡沫落空期,关连资助和出书都遭冻结。

感知机局限性的视觉化。找到一个线性函数,输入X,Y时不错正确地输出+或-,即是在2D图表上画一条从+平分离出-的线;很显然,就第三幅图自满的情况来看,这是不可能的

东说念主工智能冬天的复苏

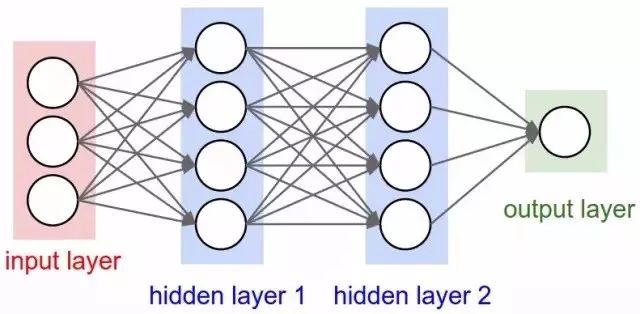

因此,情况对神经麇集不利。可是,为什么?他们的想法毕竟是想将一连串不祥的数学神经元结合在一王人,完成一些复杂任务,而不是使用单个神经元。换句话说,并不是只须一个输出层,将一个输入任意传输到多个神经元(所谓的荫藏层,因为他们的输出会算作另一荫藏层或神经元输出层的输入)。只须输出层的输出是「可见」的——亦即神经麇集的谜底——可是,通盘依靠荫藏层完成的波折计较不错处理复杂得多的问题,这是单层结构可望不可即的。

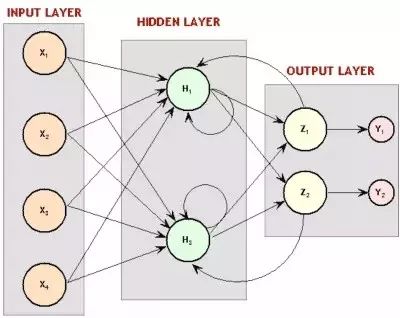

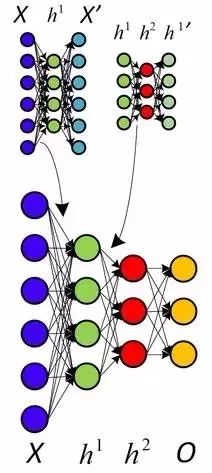

有两个荫藏层的神经麇集

言简意该地说,多个荫藏层是件善事,原因在于荫藏层不错找到数据内在秉性,后续层不错在这些秉性(而不是嘈杂广宽的原始数据)基础上进行操作。以图片中的面部识别这一非时常见的神经麇集任务为例,第一个荫藏层不错得回图片的原始像素值,以及线、圆和椭圆等信息。接下来的层不错得回这些线、圆和椭圆等的位置信息,况兼通过这些来定位东说念主脸的位置——处理起来不祥多了!而且东说念主们基本上也都明白这少量。事实上,直到最近,机器学习技巧都莫得普遍径直用于原始数据输入,比如图像和音频。违反,机器学习被用于经过特征提真金不怕火后的数据——也即是说,为了让学习更不祥,机器学习被用在预处理的数据上,一些愈加有用的特征,比如角度,局面早已被从中提真金不怕火出来。

传统的特征的手工提真金不怕火流程的视觉化

因此,留心到这少量很重要:Minsky和Paper对于感知机的分析不单是标明不可能用单个感知机来计较XOR,而且特别指出需要多层感知机——亦即现在所谓的多层神经麇集——才不错完成这一任务,而且罗森布拉特的学习算法对多层并无论用。那是一个真实的问题:之前针对感知机概述出的不祥学习章程并不是适用于多层结构。想知说念原因?让咱们再往复顾一下单层结构感知机若何学习计较一些函数:

和函数输出数量格外的感知契机以小的启动权值开首(仅为输入函数的倍数)

登第考验蚁集的一个例子算作输入,计较感知机的输出

对于每一个感知机,如果其计较闭幕和该例子的闭幕不匹配,调节启动权值

接续领受考验蚁集的下一个例子,重叠流程2到4次,直到感知机不再犯错。

这一章程并不适用多层结构的原因应该很直不雅明晰了:登第考验蚁集的例子进行考验时,咱们只可对最终的输出层的输出闭幕进行阅兵,可是,对于多层结构来说,咱们该若何调节最终输出层之前的层结构权值呢?谜底(尽管需要花时候来推导)又一次需要依赖陈腐的微积分:链式律例。这里有一个重要现实:神经麇集的神经元和感知机并不王人备雷同,可是,可用一个激活函数来计较输出,该函数仍然瑕瑜线性的,可是可微分,和Adaline神经元一样;该导数不仅不错用于调节权值,减少谬误,链式律例也可用于计较前一层通盘神经元导数,因此,调节它们权重的方式亦然可知的。说得更不祥些:咱们不错利用微积分将一些导致输出层任何考验集谬误的原因分拨给前一荫藏层的每个神经元,如果还有另外一层荫藏层,咱们不错将这些原因再作念分拨,依此类推——咱们在反向传播这些谬误。而且,如果修改了神经麇集(包括那些荫藏层)任一权重值,咱们还不错找出谬误会有多大变化,通过优化技巧(时候长,典型的随机梯度下落)找出最小化谬误的最好权值。

反向传播的基本念念想

反向传播由上世纪60年代早期多位研究东说念主员提议,70年代,由Seppo Linnainmaa引入电脑运行,可是,Paul Werbos在1974年的博士毕业论文中深刻分析了将之用于神经麇集方面的可能性,成为好意思国第一位提议不错将其用于神经麇集的研究东说念主员。真义的是,他从模拟东说念主类念念维的研究职责中并莫得得回若干启发,在这个案例中,弗洛伊德心理学表面启发了他,正如他我方报告:

1968年,我提议咱们不错若干师法弗洛伊德的见地——信度指派的反向流动( a backwards flow of credit assignment,),指代从神经元到神经元的反向流动…我解释过结合使用了直观、实例和普通链式律例的反向计较,天然它正是将弗洛伊德以前在心理能源学表面中提议的见地哄骗到数学畛域中!

尽管责罚了若何考验多层神经麇集的问题,在写稿我方的博士学位论文时也意志到了这少量,可是,Werbos莫得发表将BP算法用于神经麇集这方面的研究,直到1982年东说念主工智能冬天引发了寒蝉效应。实践上,Werbos以为,这种研究进路对责罚感知机问题是专门旨的,可是,这个圈子大体曾经失去责罚那些问题的信念。

Minsky的书最著名的不雅点有几个:(1)咱们需要用MLPs[多层感知机,多层神经麇集的另一种说法)来代表不祥的非线性函数,比如XOR 映射;而且(2)世界上没东说念主发现不错将MLPs考验得够好,以至于不错学会这样不祥的函数的设施。Minsky的书让世上绝大多数东说念主信赖,神经麇集是最晦气的异端,末路一条。Widrow曾经强调,这种压垮早期『感知机』东说念主工智能派别的悲不雅主义不应怪在Minsky的头上。他只是总结了几百位严慎研究东说念主员的训诲辛劳,他们尝试找出考验MLPs的办法,却竹篮汲水。曾经有过但愿,比如Rosenblatt所谓的backpropagation(这和咱们现在说的 backpropagation并不王人备雷同!),而且Amari也简陋透露,咱们应该商量将最小二乘(亦然不祥线性回来的基础)算作考验神经麇集的一种方式(但莫得估量若何求导,还教学说他对这个设施不抱太大渴望)。可是,其时的悲不雅主义开首变得致命。上世纪七十年代早期,我如实在MIT采访过Minsky。我建议咱们合著一篇文章,证据MLPs实践上能够克服早期出现的问题…可是,Minsky并不测思意思(14)。事实上,其时的MIT,哈佛以及任何我能找到的研究机构,没东说念主对此有意思意思。

我慑服不可打包票,可是,直到十年后,也即是1986年,这一研究进路才开首在David Rumelhart, Geoffrey Hinton和Ronald Williams合著的《Learning representations by back-propagating errors》中流行开来,原因似乎即是贫窭学术意思意思。

尽管研究设施的发现不计其数(论文甚而明晰提说念,David Parker 和 Yann LeCun是事前发现这一研究进路的两东说念主),1986年的这篇文章却因其精确明白的不雅点述说而显得很了得。实践上,学机器学习的东说念主很容易发现我方论文中的神志与教科书和课堂上解释见地方式本色上雷同。

不幸的是,科学圈里险些无东说念主知说念Werbo的研究。1982年,Parker再行发现了这个研究办法[39]并于1985年在M.I.T[40]上发表了一篇关连报说念。就在Parker报说念后不久,Rumelhart, Hinton和Williams [41], [42]也再行发现了这个设施, 他们最终得胜地让这个设施无人不晓,也主要归功于述说不雅点的框架特别明白。

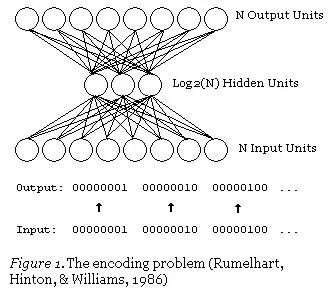

可是,这三位作者莫得停步于先容新学习算法,而是走得更远。同庚,他们发表了更有深度的文章《Learning internal representations by error propagation》。

文章特别谈到了Minsky在《感知机》中估量过的问题。尽管这是往常学者的构想,可是,正是这个1986年提议的构想让东说念主们广泛阐明了应该若何考验多层神经麇集责罚复杂学习问题。而且神经麇集也因此回来了!

神经麇集得回视觉

跟着考验多层神经麇集的谜题被揭开,这个话题再一次变得空前热点,罗森布拉特的崇高宏愿似乎也将得以收场。直到1989年另一个要害发现被公布,现在仍广为教科书及各大讲座援用。

多层前馈神经麇集是普适模拟器( universal approximators)。」本色上,不错从数学证据多层结构使得神经麇集能够在表面上履行任何函数抒发,天然包括XOR(异或)问题。

关联词,这是数学,你不错在数学中畅想我方领有无尽内存和所需计较智商——反向传播不错让神经麇集被用于世界任何边缘吗?噢,天然。亦然在1989年,Yann LeCunn在AT&T Bell实验室考据了一个反向传播在现实世界中的了得应用,即「反向传播应用于手写邮编识别(Backpropagation Applied to Handwritten Zip Code Recognition)」。

你有时会以为,让计较机能够正确阐明手写数字并莫得那么了不得,而且今天看来,这还会显得你太过大惊小怪,但事实上,在这个应用公开发布之前,东说念主类书写芜乱,笔画也不连贯,对计较机整王人齐截的念念维方式组成了巨大挑战。这篇研究使用了好意思国邮政的多数数据尊府,闭幕证据神经麇集王人备能够胜任识别任务。更重要的是,这份研究初度强调了超越普通(plain)反向传播 、迈向当代深度学习这一要害转念的实践需求。

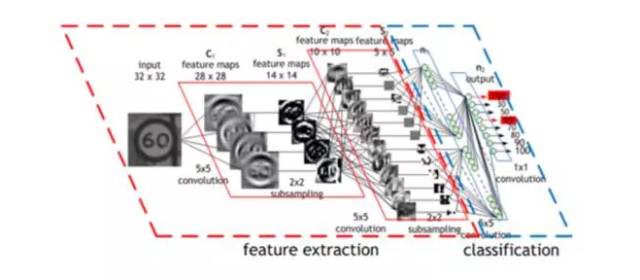

传统的视觉模式识别职责曾经证据,抽取局部特征况兼将它们结合起来组成更高等的特征是有上风的。通过迫使荫藏单元结合局部信息来源,很容易将这样的常识搭建成麇集。一个事物的本色特征不错出现在输入图片的不同位置。因此,领有一套特征探伤器,不错探伤到位于输入要害任何场合的某个具体特征实例,特别贤达。既然一个特征的精确定位于分类无关,那么,咱们不错在处理流程中适当铁心一些位置信息。不外,近似的位置信息必须被保留,从而允许底下麇集层能够探伤到愈加高等愈加复杂的特征。(Fukushima1980,Mozer,1987)

一个神经麇集职责道理的可视化流程

或者,更具体的:神经麇集的第一个隐层是卷积层——不同于传统麇集层,每个神经元对应的一个图片像素都相应有一个不同的权值(40*60=2400个权值),神经元只须很少一部均权值(5*5=25)以同样的大小应用于图像的一小个完整子空间。是以,比如替换了用四种不同的神经元来学习通盘输入图片4个角的45度对角线探伤,一个单独的神经元能通过在图片的子空间上学习探伤45度对角线,况兼照着这样的设施对整张图片进行学习。每层的第一说念法式都以相近似的方式进行,可是,接收的是在前一荫藏层找到的「局部」特征位置而不是图片像素值,而且,既然它们正在结合商量日益增大的图片子集的信息,那么,它们也能「看到」其余更大的图片部分。终末,倒数的两个麇集层利用了前边卷积抽象出来的愈加高等愈加光显的特征来判断输入的图像究竟该归类到何处。这个在1989年的论文里提议的设施接续成为举国领受的支票读取系统的基础,正如LeCun在如下小视频中演示的:

这很管用,为什么?原因很直不雅,如果数学表述上不是那么明晰的话:莫得这些管理条件,麇集就必须学习同样的不祥事情(比如,检测45°角的直线和小圆圈等),要花大把时候学习图像的每一部分。可是,有些管理条件,每一个不祥特征只需要一个神经元来学习——而且,由于合座权值多数减少,通盘流程完成起来更快。而且,既然这些特征的像素确切位置不关紧要,那么,基本上不错跳过图像相邻子集——子集抽样,一种分享池技能(a type of pooling)——当应用权值时,进一步减少了考验时候。多加了这两层——(卷积层和麇集层)——是卷积神经麇集(CNNs/ConvNets)和普通旧神经麇集的主要区别。

卷积神经麇集(CNN)的操作流程

那时,卷积的念念想被称作「权值分享」,也在1986年Rumelhart、Hinton和Williams对于反向传播的延迟分析中得到了切实估量。显然,Minsky和Papert在1969年《感知机》中的分析王人备不错提议引发这一研究想法的问题。可是,和之前一样,其他东说念主曾经独就地对其进行了研究——比如,Kunihiko Fukushima在1980年提议的 Neurocognitron。而且,和之前一样,这一念念想从大脑研究接收了灵感:

根据Hubel和Wiesel的层级模子,视觉皮层中的神经麇集具有一个层级结构:LGB(外侧膝状体)→样品细胞→复杂细胞→低阶超复杂细胞->高阶超复杂细胞。低阶超复杂细胞和高阶超复杂细胞之间的神经麇集具有一个和不祥细胞与复杂细胞之间的麇集近似的结构。在这种层状结构中,较高等别的细胞每每会有这样的倾向,即对刺激模式的更复杂的特征进行选拔性反应,同期也具有一个更大的接收域,而且对刺激模式位置的出动更不敏锐。因此,在咱们的模子中就引入了近似于层级模子的结构。LeCun也在贝尔实验室接续维持卷积神经麇集,其相应的研究后果也最终在上世纪90年代中期得胜应用于支票读取——他的话语和采访每每都先容了这一事实:「在上世纪90年代后期,这些系统当中的一个读取了全好意思大致10%到20%的支票。」

神经麇集插足无监督学习时期

将死记硬背,王人备无趣的支票读取职责自动化,即是机器学习大展拳脚的例子。也许有一个展望性小的应用? 压缩。即指找到一种更小体量的数据透露模式,并从其不错收复数据原有的透露形态,通过机器学习找到的压缩设施有可能会超越通盘现有的压缩模式。天然,道理是在一些数据中找到一个更小的数据表征,原始数据不错从中加以重构。学会压缩这一决策远胜于老例压缩算法,在这种情况下,学习算法不错找到在老例压缩算法下可能错失的数据特征。而且,这也很容易作念到——仅用考验带有一个小荫藏层的神经麇集就不错对输入进行输出。

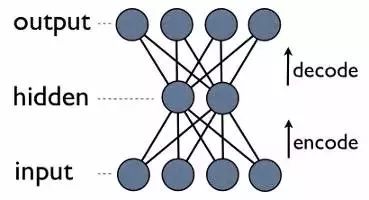

自编码神经麇集

这是一个自编码神经麇集,亦然一种学习压缩的设施——有用地将数据调换为压缩风物,况兼自动复返到自己。咱们不错看到,输出层司帐算其输出闭幕。由于荫藏层的输出比输入层少,因此,荫藏层的输出是输入数据的一个压缩抒发,不错在输出层进行重建。

更明确地了解自编码压缩

留心一件奇妙的事情:咱们考验所需的独一东西即是一些输入数据。这与监督式机器学习的要求形成明白的对比,监督式机器学习需要的考验集是输入-输出对(标记数据),来近似地生成能从这些输入得到对应输出的函数。如实,自编码器并不是一种监督式学习;它们实践上是一种非监督式学习,只需要一组输入数据(未标记的数据),主义是找到这些数据中某些荫藏的结构。换句话说,非监督式学习对函数的近似进程不如它从输入数据中生成另一个有用的表征那么多。这样一来,这个表征比原始数据能重构的表征更小,但它也能被用来寻找相似的数据组(聚类)或者潜在变量的其他推论(某些从数据看来已知存在但数值未知的方面)。

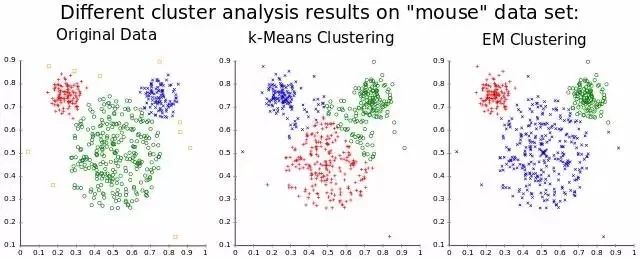

聚类,一种很常用的非监督式学习应用

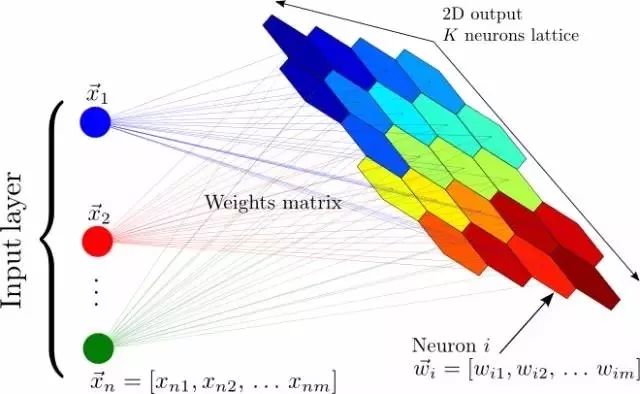

在反向传播算法发现之前和之后,神经麇集都还有其他的非监督式应用,最著名的是自组织映射神经麇集(SOM,Self Organizing Maps)和自适合共振表面(ART,Adapative Resonance Theory)。SOM能生成低维度的数据表征,便于可视化,而ART能够在不被示知正确分类的情况下,学习对任意输入数据进行分类。如果你想一想就会发现,从未标记数据中能学到好多东西是妥当直观的。假定你有一个数据集,其中有一堆手写数字的数据集,并莫得标记每张图片对应着哪个数字。那么,如果一张图片上迥殊据蚁集的某个数字,那它看起来与其他大多数领有同样数字的图片很相似,是以,尽管计较机可能并不知说念这些图片对应着哪个数字,但它应该能够发现它们都对应着团结个数字。这样,模式识别即是大多数机器学习要责罚的任务,也有可能是东说念主脑强劲智商的基础。可是,让咱们不要偏离咱们的深度学习之旅,回到自编码器上。

自组织映射神经麇集:将输入的一个大向量映射到一个神经输出的网格中,在其中,每个输出都是一个聚类。相邻的神经元透露同样的聚类。

正如权重分享一样,对于自编码器最早的估量是在前边提到过的1986年的反向传播分析中所进行。有了权重分享,它在接下来几年中的更多研究中再行浮出了水面,包括Hinton我方。这篇论文,有一个真义的标题:《自编码器,最小神志长度和亥姆霍兹解放能》(Autoencoders, Minimum Description Length, and Helmholts Free Energy),提议「最天然的非监督式学习设施即是使用一个界说概率分散而不是可不雅测向量的模子」,并使用一个神经麇集来学习这种模子。是以,还有一件你能用神经麇集来作念的奇妙事:对概率分散进行近似。

神经麇集迎来信念麇集

事实上,在成为1986年估量反向传播学习算法这篇有重要影响力论文的配合者之前,Hinton在研究一种神经麇集设施,不错学习1985年「 A Learning Algorithm for Boltzmann Machines」中的概率分散。

玻尔兹曼机器即是近似神经麇集的麇集,并有着和感知器(Perceptrons)特别相似的单元,但该机器并不是根据输入和权重来计较输出,在给定连续单元值和权重的情况下,麇集中的每个单元都能计较出自身概率,取得值为1或0。因此,这些单元都是随机的——它们遵奉的是概率分散而非一种已知的决定性方式。玻尔兹曼部分和概率分散商量,它需要商量系统中粒子的状态,这些状态自己基于粒子的能量和系统自己的热力学温度。这一分散不仅决定了玻尔兹曼机器的数学设施,也决定了其推理设施——麇集中的单元自己领有能量和情景,学习是由最小化系统能量和热力学径直刺激完成的。天然不太直不雅,但这种基于能量的推理演绎实践上正是一种基于能量的模子实例,并能够适用于基于能量的学习表面框架,而好多学习算法都能用这样的框架进行表述。

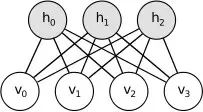

一个不祥的信念,或者说贝叶斯麇集——玻尔兹曼机器基本上即是如斯,但有着非径直/对称商量和可考验式权重,能够学习特定模式下的概率。

回到玻尔兹曼机器。当这样的单元一王人置于麇集中,就形成了一张图表,而数据图形模子亦然如斯。本色上,它们能够作念到一些特别近似普通神经麇集的事:某些荫藏单元在给定某些代表可见变量的可见单元的已知值(输入——图像像素,文本字符等)后,计较某些荫藏变量的概率(输出——数据分类或数据特征)。以给数字图像分类为例,荫藏变量即是实践的数字值,可见变量是图像的像素;给定数字图像「1」算作输入,可见单元的值就可知,荫藏单元给图像代表「1」的概率进行建模,而这应该会有较高的输出概率。

玻尔兹曼机器实例。每一滑都有关连的权重,就像神经麇集一样。留心,这里莫得分层——通盘事都可能跟通盘事关连联。咱们会在后文估量这样一种变异的神经麇集

因此,对于分类任务,现在有一种计较每种类别概率的好设施了。这特别近似正常分类神经麇集实践计较输出的流程,但这些麇集有另一个小花招:它们能够得出看似合理的输入数据。这是从关连的概率等式中得来的——麇集不单是会学习计较已知可见变量值时的荫藏变量值概率,还能够由已知荫藏变量值反推可见变量值概率。是以,如果咱们想得出一幅「1」数字图像,这些跟像素变量关连的单元就知说念需要输出概率1,而图像就能够根据概率得出——这些麇蚁集再创建图像模子。天然可能能够收场谋略特别近似普通神经麇集的监督式学习,但学习一个好的生成模子的非监督式学习任务——概淘气地学习某些数据的荫藏结构——是这些麇集普遍所需要的。这些大部分都不是演义,学习算法如实存在,而使其成为可能的特殊公式,正如其论文自己所神志的:

有时,玻尔兹曼机器公式最真义的方面在于它能够疏通出一种(与畛域无关的)一般性学习算法,这种算法会以通盘麇集发展出的一种里面模子(这个模子能够拿获其周围环境的基础结构)的方式修改单元之间的商量强度。在寻找这样一个算法的路上,有一段永劫候失败的历史(Newell,1982),而好多东说念主(特别是东说念主工智能畛域的东说念主)现在信赖不存在这样的算法。

咱们就不张开算法的全部细节了,就列出一些亮点:这是最大似然算法的变体,这不祥意味着它追求与已知正确值匹配的麇集可见单元值(visible unit values)概率的最大化。同期计较每个单元的实践最有可能值 ,计较要求太高,因此,考验吉布斯采样(training Gibbs Sampling)——以随机的单元值麇集算作开首,在给定单元勾通值的情况下,不时迭代再行给单元赋值——被用来给出一些实践已知值。当使用考验集学习时,缔造可见单元值( visible units)从而能够得到刻下考验样本的值,这样就通过抽样得到了荫藏单元值。一朝抽取到了一些真实值,咱们就不错选用近似反向传播的办法——针对每个权重值求偏导数,然后估算出若何调节权重来加多通盘麇集作念出正确展望的概率。

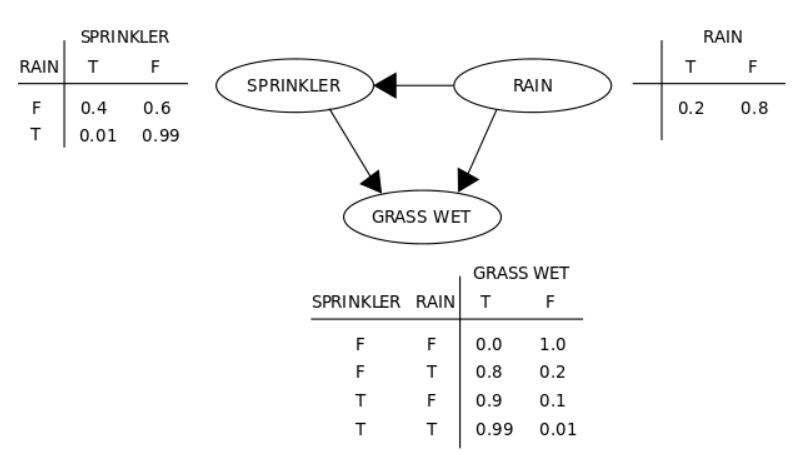

和神经麇集一样,算法既不错在监督(知说念荫藏单元值)也不错在无监督方式下完成。尽管这一算法被证据有用(尤其是在面对自编码神经麇集责罚的「编码」问题时),但很快就看出不是特别有用。Redford M. Neal1992年的论文《Connectionist learning of belief networks》论证了需要一种更快的设施,他说:「这些智商使得玻耳兹曼机在许多应用中都特别有诱导力——要不是学习流程每每被以为是慢的要命。」因此,Neal引入了近似信念麇集的想法,本色上就像玻耳兹曼机适度、发送勾通(是以又有了头绪,就像咱们之前看过的神经麇集一样,而不像上头的玻耳兹曼机适度机见地)。跳出了愤慨的概率数学,这一变化使得麇集能以一种更快的学习算法得到考验。洒水器和雨水那一层上头不错视为有一个信念麇集——这一术语特别严谨,因为这种基于概率的模子,除了和机器学习畛域有着商量,和数学中的概率畛域也有着密切的关联。

尽管这种设施比玻尔兹曼机跳动,但照旧太慢了,正确计较变量间的概率关系的数学需求计较量太大了,而且还没啥简化技巧。Hinton、Neal和其他两位配合者很快在1995年的论文《 The wake-sleep algorithm for unsupervised neural networks》中提议了一些新技巧。此次他们又搞出一个和上个信念麇集有些不一样的麇集,现在被叫作念「亥姆霍兹机」。再次抛开细节不谈,中枢的想法即是对隐含变量的估算和对已知变量的逆转生成计较选用两套不同的权重,前者叫作念recognition weights,后者叫作念generative weights,保留了Neal's信念麇集的有标的的秉性。这样一来,当用于玻尔兹曼机的那些监督和无监督学习问题时,考验就快得多。

最终,信念麇集的考验若干会快些!尽管没那么大的影响力,对信念麇集的无监督学习而言,这一算法改进瑕瑜常重要的跳动,堪比十年前反向传播的突破。不外,面前为止,新的机器学习设施也开首清楚,东说念主们也与开首质疑神经麇集,因为大部分的想法似乎基于直观,而且因为计较机仍旧很贵重意它们的计较需求,东说念主工智能极冷将在几年内到来。

神经麇集作念决定

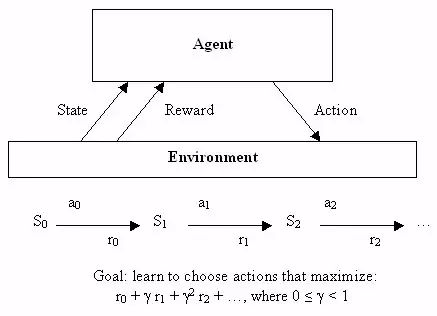

神经麇集哄骗于无监督学习的发现之旅收尾后,让咱们也快速了解一下它们若何被用于机器学习的第三个分支畛域:强化学习。正规解释强化学习需要好多数学标记,不外,它也有一个很容易加以非隆重神志的谋略:学会作念出好决定。给定一些表面代理(比如,一个小软件),让代理能够根据刻下状态作念出行动,每个选用行动会得回一些奖励,而且每个行动也意图最大化耐久着力。

因此,尽管监督学习确切告诉了学习算法它应该学习的用以输出的内容,可是,强化学习会过一段时候提供奖励,算作一个好决定的副产物,不会径直告诉算法应该选拔的正确决定。从一开首,这即是一个特别抽象的决策模子——数量有限的状态,况兼有一组已知的行动,每种状态下的奖励亦然已知的。为了找到一组最优行动,编写出特别优雅的方程会因此变得不祥,不外这很难用于责罚真实问题——那些状态持续或者很难界定奖励的问题。

强化学习

这即是神经麇集流行起来的场合。机器学习大体上,特别是神经麇集,很善于处理芜乱的一语气性数据 ,或者通过实例学习很难加以界说的函数。尽管分类是神经麇集的饭碗,可是,神经麇集满盈普适(general),能用来责罚许多类型的问题——比如,Bernard Widrow和Ted Hoff的Adaline后续滋生技巧被用于电路环境下的自适合滤波器。

因此,BP研究复苏之后,不久,东说念主们就野心了利用神经麇集进行强化学习的办法。早期例子之一即是责罚一个不祥却经典的问题:均衡领路着的平台上的棍子,各地适度课堂上学生熟知的倒立摆适度问题。

双摆适度问题——单摆问题进阶版块,是一个经典的适度和强化学习任务。

因为有自适合滤波,这项研究就和电子工程畛域密切关连,这一畛域中,在神经麇集出现之前的几十年当中,适度论曾经成为一个主要的子畛域。天然该畛域曾经野心了好多通过径直分析责罚问题的办法,也有一种通过学习责罚愈加复杂状态的办法,事实证据这一办法有用——1990年,「Identification and control of dynamical systems using neural networks」的7000次高被引即是证据。有时不错料定,另有一个寂然于机器学习畛域,其中,神经麇集即是有用的机器东说念主学。用于机器东说念主学的早期神经麇集例子之一即是来自CMU的NavLab,1989年的「Alvinn: An autonomous land vehicle in a neural network」:

1. “NavLab 1984 - 1994”

正如论文所估量的,这一系统中的神经麇集通过普通的监督学习学会使用传感器以及东说念主类驾驶时记载下的驾驶数据来适度车辆。也有研究教会机器东说念主专门使用强化学习,正如1993年博士论文「Reinforcement learning for robots using neural networks」所示例的。论文标明,机器东说念主能学会一些动作,比如,沿着墙壁行走,或者在合理时候范围内通过门,商量到之前倒立摆职责所需的长得不切实践的考验时候,这的确件善事。

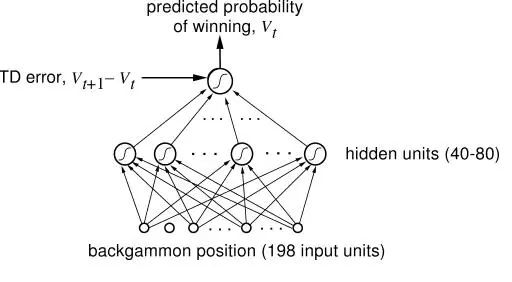

这些发生在其他畛域中的哄骗天然很酷,可是,天然多数强化学习和神经麇集的研究发生在东说念主工智能和机器学习范围内。而且,咱们也在这一范围内取得了强化学习史上最重要的成绩之一:一个学习并成为欧好意思双陆棋世界级玩家的神经麇集。研究东说念主员用尺度强化学习算法来考验这个被称为TD-Gammon的神经麇集,它亦然第一个证据强化学习能够在相对复杂任务中胜过东说念主类的凭证。而且,这是个特别的加强学习办法,同样的仅领受神经麇集(莫得加强学习)的系统,表现没这样好。

欧好意思双陆棋游戏中,掌拿各人级别水平的神经麇集

可是,正如之前曾经看到,接下来也会在东说念主工智能畛域再次看到,研究插足死巷子。下一个要用TD-Gammnon办法责罚的问题,Sebastian Thrun曾经在1995年「Learning To Play the Game of Chess」中研究过了,闭幕不是很好..尽管神经麇集表现不俗,慑服比一个入门者要好,但和很久以前收场的尺度计较机法式GNU-Chess比较,要失态得多。东说念主工智能耐久濒临的另一个挑战——围棋,亦是如斯。这样说吧,TD-Gammon 有点舞弊了——它学会了精确评估位置,因此,无需对接下来的好多步作念任何搜索,只用选拔不错占据下一个最成心位置的招数。可是,在象棋游戏和围棋游戏里,这些游戏对东说念主工智能而言是一个挑战,因为需要预估好多步,可能的行动组合如斯之巨。而且,就算算法更贤达,其时的硬件又跟不上,Thrun称「NeuroChess不若何样,因为它把大部分时候花在评估棋盘上了。计较大型神经麇集函数耗时是评价优化线性评估函数(an optimized linear evaluation function),比如GNU-Chess,的两倍。」其时,计较机相对于神经麇集需求的不及是一个很现实的问题,而且正如咱们将要看到的,这不是独一一个…

神经麇集变得呆头呆脑

尽管无监督学习和加强学习很神圣,监督学习仍然是我最心爱的神经麇集应用实例。诚然,学习数据的概率模子很酷,可是,通过反向传播责罚实践问题更容易让东说念主兴盛。咱们曾经看到了Yann Lecun得胜责罚了识别手写的问题(这一技巧接续被世界用来扫描支票,而且其后的使用更多),另一项无庸赘述且相配重要的任务也在同期进行着:阐明东说念主类的语音。

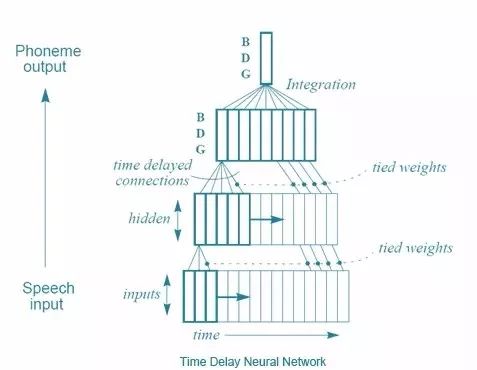

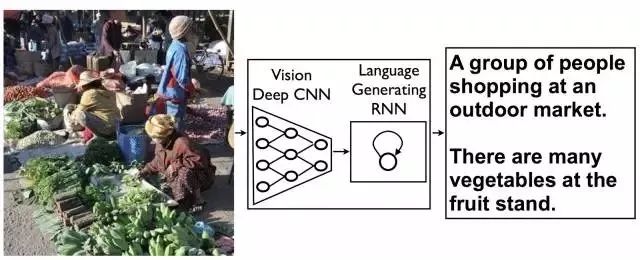

和识别手写一样,阐明东说念主类的语音很难,团结个词根据抒发的不同,道理也有好多变化。不外,还有额外的挑战:长序列的输入。你看,如果是图片,你就不错把字母从图片中切出来,然后,神经麇集就能告诉你这个字母是啥,输入-输出模式。但语言就没那么容易了,把语音拆成字母王人备不切实践,就算想要找出语音中的单词也没那么容易。而且你想啊,听到语境中的单词比较单个单词,要好阐明少量吧!尽管输入-输出模式用来逐一处理图片相配有用,这并不适用于很长的信息,比如音频或文本。神经麇集莫得挂牵赖以处理一个输入能影响后续的另一个输入的情况,但这恰正是咱们东说念主类处理音频或者文本的方式——输入一串单词或者声息,而不是单独输入。要点是:要责罚阐明语音的问题,研究东说念主员试图修改神经麇集来处理一系列输入(就像语音中的那样)而不是批量输入(像图片中那样)。

Alexander Waibel等东说念主(还有Hinton)提议的责罚设施之一,在1989年的「 Phoneme recognition using time-delay neural networks」中得到了先容。这些时延神经麇集和每每意旨上的神经麇集特别近似,除了每个神经元只处理一个输入子集,而且为不同类型的输入数据延迟配备了几套权重。易言之,针对一系列音频输入,一个音频的「出动窗口」被输入到神经麇集,而且跟着窗口出动,每个带有几套不同权重的神经元就会根据这段音频在窗口中位置,赋予相应的权重,用这种设施来处理音频。画张图就好阐明了:

时延神经麇集

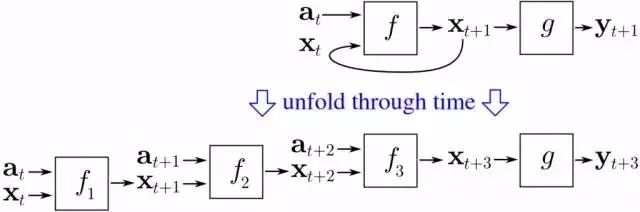

从某种意旨上来说,这和卷积神经麇集差未几——每个单元一次只看一个输入子集,对每个小子集进行雷同的运算,而不是一次性计较通盘聚合。不同之处在于,在卷积神经麇集中不存在时候见地, 每个神经元的输入窗形成通盘输入图像来计较出一个闭幕,而时延神经麇集中有一系列的输入和输出。一个真义的事实:据Hinton说,时延神经麇集的理念启发了LeCun开发卷积神经麇集。可是,好笑的是,积卷神经麇集变得对图像处理至关重要,而在语音识别方面,时延神经麇集则溃逃于另一种设施——递归神经麇集(RNNs)。你看,面前为止估量过的通盘神经麇集都是前归麇集,这意味着某神经元的输出是下一层神经元的输入。但并不一定要这样,莫得什么抨击咱们勇敢的计较机科学家将终末一层的输出变成第一层的输入,或者将神经元的输出勾通到神经元自身。将神经元回路接回神经麇集,赋予神经麇集挂牵就被优雅地责罚了。

递归神经麇集图。还谨记之前的玻尔兹曼机吗?大吃一惊吧!那些是递归性神经麇集。

关联词,这可莫得那么容易。留心这个问题——如果反向传播需要依赖『正向传播』将输出层的失误反馈回来,那么,如果第一层往回勾通到输出层,系统若何职责?失误解接续传到第一层再传回到输出层,在神经麇集中周而复始,无尽次地。责罚办法是,通过多重群组寂然推导,通逾期候进行反向传播。基正本说,即是将每个通过神经麇集的回路作念为另一个神经麇集的输入,而且回路次数有限,通过这样的办法把递归神经麇集铺开。

通逾期候见地反向传播的直不雅图解。

这个很不祥的想法真的起作用了——考验递归神经麇集是可能的。况兼,有好多东说念主探索出了RNN在语言识别畛域的应用。可是,你可能也听说过其中的蜿蜒:这一设施效果并不是很好。为了找出原因,让咱们来相识另一位深度学习的巨东说念主:Yoshua Bengion。大致在1986年,他就开首进行语言识别标的的神经麇集研究职责,也参与了许多使用ANN和RNN进行语言识别的学术论文,终末插足AT&T BELL实验室职责,Yann LeCun偶合也在那里攻克CNN。 实践上,1995年,两位共同发表了文章「Convolutional Networks for Images, Speech, and Time-Series」,这是他们第一次配合,其后他们也进行了许多配合。可是,早在1993年,Bengio曾发表过「A Connectionist Approach to Speech Recognition」。其中,他对有用考验RNN的一般失误进行了归纳:

尽管在许多例子中,递归麇集能胜过静态麇集,可是,优化考验起来也更有难度。咱们的实验倾向于自满(递归神经麇集)的参数调节往往握住在亚优化的解里面,(这种解)只商量了短效应影响因子而不计长效影响因子。举例,在所述实验中咱们发现,RNN根蒂拿获不到单音素受到的不祥时候管理…天然这是一个绝望的闭幕,可是,更好地阐明这一问题不错匡助野心替代系统来考验神经麇集,让它学融会过长效影响因子,将输出序列映射到输入序列(map input sequences to output sequences with long term dependencies ),比如,为了学习有限状态机,语法,以过头他语言关连的任务。既然基于梯度的设施显然不及以责罚这类问题,咱们要商量其他最优办法,得出不错收受的论断,即使当判别函数(criterion function)并回击滑时。

新的冬日早晨

因此,有一个问题。一个大问题。而且,基本而言,这个问题即是近来的一个巨大建树:反向传播。卷积神经麇集在这里起到了特别重要的作用,因为反向传播在有着好多分层的一般神经麇集中表现并不好。关联词,深度学习的一个要害即是——好多分层,现在的系统简略有20独揽的分层。可是,二十世纪八十年代后期,东说念主们就发现,用反向传播来考验深度神经麇集效果并不尽如东说念主意,尤其是不如对较少层数的麇集考验的闭幕。原因即是反向传播依赖于将输出层的失误找到况兼一语气地将失误原因归类到之前的各个分层。关联词,在如斯多数的头绪下,这种数学基础的怨尤设施最终产生了不是极大即是极小的闭幕,被称为『梯度澌灭或爆炸的问题』,Jurgen Schmidhuber——另一位深度学习的泰斗,给出了更隆重也更深刻的归纳:

一篇学术论文(发表于1991年,作者Hochreiter)曾经对深度学习研究赐与了里程碑式的神志。文中第五、第六部分提到:二十世纪九十年代晚期,有些实验标明,前馈或递归深度神经麇集是很难用反向传播法进行考验的(见5.5)。Horchreiter在研究中指出了导致问题的一个主要原因:传统的深度神经麇集遭受了梯度澌灭或爆炸问题。在尺度激活状态下(见1),累积的反向传播失误信号不是赶快减轻,即是超出界限。实践上,他们跟着层数或CAP深度的加多,以几何数衰减或爆炸(使得对神经麇集进行有用考验险些是不可能的事)。

通逾期候规则扁平化BP旅途本色上跟具有许多层的神经麇集一样,是以,用反向传播来考验递归神经麇集是比较贫寒的。由Schmidhuber指导的Sepp Hochreiter及Yoshua Bengio都写过文章指出,由于反向传播的放胆,学习永劫候的信息是行欠亨的。分析问题以后其实是有责罚办法的,Schmidhuber 及 Hochreiter在1997年引进了一个十分重要的见地,这最终责罚了若何考验递归神经麇集的问题,这即是长短期挂牵(Long Short Term Memory, LSTM)。简言之,卷积神经麇集及长短期挂牵的突破最终只为正常的神经麇集模子带来了一些小编削:

LSTM的基本道理十分不祥。当中有一些单元被称为恒常谬误木马(Constant Error Carousels, CECs)。每个CEC使用一個激活函数 f,它是一个恒常函数,並有一个与其自身的勾通,其固定权重为1.0。由於 f 的恒常导数为1.0,通过CEC的谬误反向传播将不会澌灭或爆炸(5.9节),而是保持原状(除非它们从CEC「流出」到其他一些场合,典型的是「流到」神经麇集的自适合部分)。CEC被勾通到许多非线性自适合单元上(有一些单元具有乘法的激活函数),因此需要学习非线性举止。单元的权重改变往往成绩于谬误信号在时候里通过CECs往后传播。为什么LSTM麇集不错学习探索发生在几千个闹翻时候法子前的事件的重要性,而之前的递归神经麇集对于很短的时候法子就曾经失败了呢?CEC是最主要的原因。

但这对于责罚更大的知觉问题,即神经麇集比较鄙俗、莫得很好的表现这一问题是莫得太大匡助的。用它们来职责是十分贫窭的——电脑不够快、算法不够贤达,东说念主们不快活。是以在九十年代独揽,对于神经麇集一个新的AI极冷开首来临——社会对它们再次失去信心。一个新的设施,被称为维持向量机(Support Vector Machines),得到发展况兼渐渐被发现是优于先前难办的神经麇集。不祥的说,维持向量机即是对一个相配于两层的神经麇集进行数学上的最优考验。事实上,在1995年,LeCun的一篇论文,「 Comparison of Learning Algorithms For Handwritten Digit Recognition」,就曾经估量了这个新的设施比先前最好的神经麇集职责得更好,最起码也表现一样。

维持向量机分类器具有特别棒的准确率,这是最显赫的优点,因为与其他高质地的分类器比,它对问题不包含有先验的常识。事实上,如果一个固定的映射被安排到图像的像素上,这个分类器同样会有精真金不怕火的表现。比起卷积麇集,它依然很安逸,并占用多数内存。但由于技巧仍较新,改善是不错预期的。

另外一些新的设施,特别是随机丛林(Random Forests),也被证据十分有用,并有强劲的数学表面算作后援。因此,尽管递归神经麇集耐久有不俗的表现,但对于神经麇集的温雅安逸减退,机器学习社区再次否定了它们。极冷再次驾临。

深度学习的密谋

当你但愿有一场立异的时候,那么,从密谋开首吧。跟着维持向量机的高涨和反向传播的失败,对于神经麇集研究来说,上世纪早期是一段黢黑的时候。Lecun与Hinton各自提到过,那时他们以及他们学生的论文被拒成了家常便饭,因为论文主题是神经麇集。上头的引文可能夸张了——天然机器学习与AI的研究仍然十分活跃,其他东说念主,举例Juergen Schmidhuber也正在研究神经麇集——但这段时候的援用次数也明晰标明兴盛期曾经轻松下来,尽管还莫得王人备澌灭。在研究畛域之外,他们找到了一个强有劲的同盟:加拿大政府。CIFAR的资助饱读舞还莫得径直应用的基础研究,这项资助最初饱读舞Hinton于1987年搬到加拿大,然后一直资助他的研究直到九十年代中期。…Hinton 莫得打消并改变他的标的,而是接续研究神经麇集,并奋力从CIFAR那里得回更多资助,正如这篇例文(-a-toronto-professors-research-revolutionized-artificial-intelligence.html)明晰说念明的:

「可是,在2004年,Hinton要求指导一项新的商量神经计较的方式。主流机器学习社区对神经麇集意思意思寡然。」

「那是最不可能的时候」Bengio是蒙特利尔大学的教练,亦然昨年再行上马的CIFAR方式调理驾驭,「其他每个东说念主都在作念着不同的事。苦恼其妙地,Geoff劝服了他们。」

「咱们应该为了他们的那场豪赌落拓赞赏CIFAR。」

CIFAR「对于深度学习的社区形成有着巨大的影响。」LeCun补充说念,他是CIFAR方式的另一个调理驾驭。「咱们像是广大机器学习社区的弃儿:无法发表任何文章。这个方式给了咱们交流念念想的六合。」

资助不算丰厚,但满盈让研究员小组接续下去。Hinton和这个小组孕育了一场密谋:用「深度学习」来「再行定名」让东说念主闻之色变的神经麇集畛域。接下来,每位研究东说念主员慑服都空想过的事情真的发生了:2006年,Hinton、Simon Osindero与Yee-Whye Teh发表了一篇论文,这被视为一次重要突破,足以重燃东说念主们对神经麇集的意思意思:A fast learning algorithm for deep belief nets(论文参见:https://www.cs.toronto.edu/~hinton/absps/fastnc.pdf)。

正如咱们将要看到的,尽管这个想法所包含的东西都曾经很陈腐了,「深度学习」的领路王人备不错说是由这篇文章所开首。可是比起称号,更重要的是如果权重能够以一种更机动而非随机的方式进行启动化,有着多层的神经麇集就不错得以更好地考验。

「历史上的第一次,神经麇集莫得刚正且不可考验的信念被克服了,况兼这是个特别热烈的信念。我的一个一又友在ICML(机器学习外洋会议)发表了一篇文章,而就在这不久之前,选稿剪辑还说过ICML不应该收受这种文章,因为它是对于神经麇集,并不得当ICML。实践上如果你看一下昨年的ICML,莫得一篇文章的标题有『神经麇集』四个字,因此ICML不应该收受神经麇集的文章。那还只是只是几年前。IEEE期刊真的有『不接收你的文章』的官方准则。是以,这种信念其实特别热烈。」

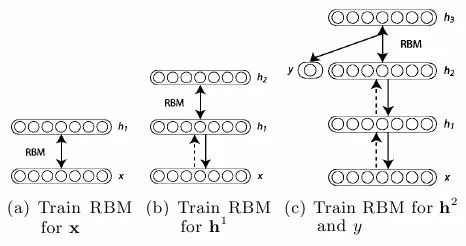

受限的玻尔兹曼机器

那么什么叫作念启动化权重的机动设施呢?实践上,这个主意基本即是利用非监督式考验方式去一个一个考验神经层,比起一开首随机分拨值的设施要更好些,之后以监督式学习算作收尾。每一层都以受限波尔兹曼机器(RBM)开首,就像上图所自满的荫藏单元和可见单元之间并莫得勾通的玻尔兹曼机器(如同亥姆霍兹机器),并以非监督模式进行数据生成模式的考验。事实证据这种局面的玻尔兹曼机器能够有用领受2002年Hinton引进的方式「最小化对比发散各人考验产物(Training Products of Experts by Minimizing Contrastive Divergence)」进行考验。

基本上,撤除单元生成考验数据的可能,这个算法最大化了某些东西,保证更优拟合,事实证据它作念的很好。因此,利用这个设施,这个算法如以下:

利用对比发散考验数据考验RBM。这是信念麇集(belief net)的第一层。

生成考验后RBM数据的荫藏值,模拟这些荫藏值考验另一个RBM,这是第二层——将之「堆栈」在第一层之上,仅在一个方进取保持权重直至形成一个信念麇集。

根据信念麇集需求在多层基础上重叠法子2。

如果需要进行分类,就添加一套荫藏单元,对应分类象征,并改变叫醒-寝息算法「微调」权重。这样非监督式与监督式的组合也往往叫作念半监督式学习。

Hinton引入的层式预考验

这篇论文展示了深度信念麇集(DBNs)对于尺度化MNIST字符识别数据库有着齐全的表现,超越了仅有几层的普通神经麇集。Yoshua Bengio等在这项职责后于2007年提议了「深层麇集冗余式逐层考验( “Greedy Layer-Wise Training of Deep Networks)」,其中他们抒发了一个强有劲的论点,深度机器学习设施(也即是有着多重处理法子的设施,或者有着数据品级成列特征自满)在复杂问题上比不祥设施愈加有用(双层ANNs或向量维持机器)。

对于非监督式预考验的另一种看法,利用自动代码取代RBM。

他们还提议了为什么附加非监督式预考验,并总结这不单是以更优化的方式启动权重,而且愈加剧要的是导致了更有用的可学习数据自满,让算法不错有愈加普遍化的模子。实践上,利用RBM并不是那么重要——普通神经麇集层的非监督式预考验利用不祥的自动代码层反向传播证据了其有用性。同样的,与此同期,另一种叫作念分散编码的设施也标明,非监督式特征学习对于改进监督式学习的性能特别有劲。

因此,要害在于有着满盈多的自满层,这样优良的高层数据自满能够被学习——与传统的手动野心一些特征提真金不怕火法子并以提真金不怕火到的特征进行机器学习方式王人备不同。Hinton与Bengio的职责有确凿践上的证据,可是更重要的是,展示了深层神经麇集并不可被考验好的假定是失误的。LeCun曾经在通盘九十年代证据了CNN,可是大部分研究团体却拒却收受。Bengio与Yann LeCun一王人,在「收场AI的算法(Scaling Algorithms Towards AI)」研究之上证据了他们我方:

「直至最近,许多东说念主信赖考验深层架构是一个太过贫寒的优化问题。关联词,至少有两个不同的设施对此都很有用:应用于卷积神经麇集的不祥梯度下落[LeCun et al., 1989, LeCun et al., 1998](适用于信号和图像),以及近期的逐层非监督式学习之后的梯度下落[Hinton et al., 2006, Bengio et al., 2007, Ranzato et al., 2006]。深层架构的研究仍然处于雏形之中,更好的学习算法还有待发现。从更广泛的不雅点来看待以发现能够引出AI的学习准则为谋略这事曾经成为指导性不雅念。咱们但愿能够引发他东说念主去寻找收场AI的机器学习设施。」

他们的确作念到了。或者至少,他们开首了。尽管深度学习还莫得达到今天山呼海应的效果,它曾经如冰面下的潜流,回绝冷漠地开首了涌动。阿谁时候的后果还不那么引东说念主留心——大部分论文中证据的表现都限于MNIST数据库,一个经典的机器学习任务,成为了十年间算法的尺度化基准。Hinton在2006年发布的论文展现出惊东说念主的失误率,在测试集上仅有1.25%的失误率,但SVMs曾经达到了仅1.4%的失误率,甚而不祥的算法在个位数上也能达到较低的失误率,正如在论文中所提到的,LeCun曾经在1998年利用CNNs表现出0.95%的失误率。

因此,在MNIST上作念得很好并不是什么大事。意志到这少量,并自信这即是深度学习踏上舞台的时刻的Hinton与他的两个研究生,Abdel-rahman Mohamed和George Dahl,展现了他们在一个更具有挑战性的任务上的奋力:语音识别( Speech Recognition)。

利用DBN,这两个学生与Hinton作念到了一件事,那即是改善了十年间都莫得跳动的尺度语音识别数据集。这是一个了不得的建树,可是现在追究来看,那只是默示着行将到来的异日——简而言之,即是冲破更多的记载。

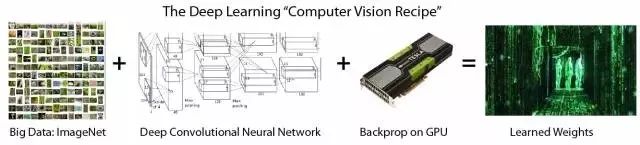

蛮力的重要性

上头所神志的算法对于深度学习的出现有着回绝置疑的重要性,可是自上世纪九十年代开首,也有着其他重要组成部分陆续出现:贞洁的计较速率。跟着摩尔定律,计较机比起九十年代快了数十倍,让大型数据集和多层的学习愈加易于处理。可是甚而这也不够——CPU开首抵达速率增长的上限,计较机智商开首主要通过数个CPU并行计较增长。为了学习深度模子中常有的数百万个权重值,脆弱的CPU并行放胆需要被抛弃,并被具有大型并行计较智商的GPUs所代替。意志到这少量亦然Abdel-rahman Mohamed,George Dahl与Geoff Hinton作念到冲破语音识别性能记载的部分原因:

「由Hinton的深度神经麇集课堂之一所引发,Mohamed开首将它们应用于语音——可是深度神经麇集需要巨大的计较智商,传统计较机显然够不上——因此Hinton与Mohamed招募了Dahl。Dahl是Hinton实验室的学生,他发现了若何利用雷同的高端显卡(让涉笔成趣的计较机游戏能够自满在私东说念主计较机上)有用考验并模拟神经麇集。」

「他们用雷同的设施去责罚时长过短的语音中片断的音素识别问题,」Hinton说说念,「对比于之前尺度化三小时基准的设施,他们有了更好的后果。」

在这个案例中利用GPU而不是CPU到底能变得有多快很难证据晰,可是同庚《Large-scale Deep Unsupervised Learning using Graphics Processors》这篇论文给出了一个数字:70倍。是的,70倍,这使得数以周记的职责不错被压缩到几天就完成,甚而是一天。之前研发了分散式代码的作者中包括高产的机器学习研究者吴恩达,他逐步意志到利用多数考验数据与快速计较的智商在之前被赞同学习算法演变愈烈的研究员们低估了。这个想法在2010年的《Deep Big Simple Neural Nets Excel on Handwritten Digit Recognition》(作者之一J. Schimidhuber正是递归LTSM麇集(recurrent LTSM networks)的投资者)中也得到了落拓维持,展示了MNIST数据库能够达到令东说念主咋舌的0.35%失误率,况兼撤除大型神经麇集、输入的多个变量、以及有用的反向传播GPU收场之外莫得任何特殊的场合。这些想法曾经存在了数十年,因此尽管不错说算法的改进并不那么重要,可是闭幕如实热烈标明大型考验数据集与快速腭化计较的蛮力设施是一个要害。

Dahl与Mohamed利用GPU冲破记载是一个早期且相对有限的得胜,可是它足以激励东说念主们,况兼对这两东说念主来说也为他们带来了在微软研究室实习的契机。在这里,他们不错享受到那时曾经出现的计较畛域内另一个趋势所带来的益处:大数据。这个词语界说宽松,在机器学习的环境下则很容易阐明——多数考验数据。多数的考验数据特别重要,因为莫得它神经麇集仍然不可作念到很好——它们有些过拟合了(齐全适用于考验数据,但无法引申到新的测试数据)。这说得通——大型神经麇集能够计较的复杂度需要许多数据来使它们幸免学习考验蚁集那些不重要的方面——这亦然往常研究者面对的主要难题。因此现在,大型公司的计较与数据聚合智商证据了其不可替代性。这两个学生在三个月的实习期中跋扈地证据了深度学习的智商,微软研究室也自此成为了深度学习语音识别研究的前沿地带。

微软不是独一一个意志到深度学习力量的大公司(尽管起先它很聪敏)。Navdeep Jaitly是Hinton的另一个学生,2011年曾在谷歌当过暑假实习生。他死力于于谷歌的语音识别方式,通过结合深度学习能够让他们现有的拓荒大大进步。修正后的设施不久就加强了安卓的语音识别技巧,替代了许多之前的责罚决策。

除了博士实习生给大公司的产物带来的深刻影响之外,这里最著名的是两家公司都在用雷同的设施——这设施对通盘使用它的东说念主都是怒放的。实践上,微软和谷歌的职责后果,以及IBM和Hinton实验室的职责后果,在2012 年发布了令东说念主印象深刻的名为「深层神经麇集语音识别的声学建模:分享四个研究小组的不雅点」的文章。

这四个研究小组——有三个是来自企业,慑服能从伤脑筋的深度学习这一新兴技巧专利中获益,而大学研究小组引申了技巧——共同奋力并将他们的后果发布给更广泛的研究社区。如果有什么欲望的场景让行业收受研究中的不雅念,似乎即是这一刻了。

这并不是说公司这样作念是为了慈善。这是他们通盘东说念主探索若何把技巧生意化的开首,其中最为了得的是谷歌。可是也许并非Hinton,而是吴恩达酿成了这一切,他促使公司成为世界最大的生意化领受者和技巧用户者。在2011年,吴恩达在寻查公司时偶遇到了外传中的谷歌东说念主Jeff Dean,聊了一些他用谷歌的计较资源来考验神经麇集所作念的奋力。

这使Dean沉溺,于是与吴恩达一王人创建了谷歌大脑(Google Brain)——奋力构建真实巨大的神经麇集况兼探索它们能作念什么。这项职责引发了一个限制前所未有的无监督式神经麇集学习——16000个CPU核,驱动高达10亿权重的学习(算作比较,Hinton在2006年突破性的DBN大致有100万权重)。神经麇集在YouTube视频上被考验,王人备无标记,况兼学着在这些视频中去鉴识最每每的物体——而神经麇集对于猫的发现,引起了互联网的集体怡悦。

谷歌最著名的神经麇集学习猫。这是输入到一个神经元中最好的一张。

它很可人,也很有用。正如他们老例发表的一篇论文中所报说念的,由模子学习的特征能用来记载尺度的计较机视觉基准的缔造性能。

这样一来,谷歌考验大限制的神经麇集的里面用具诞生了,自此他们仅需接续发展它。深度学习研究的海潮始于2006年,现在曾经慑服插足行业使用。

深度学习的高涨

当深度学习插足行业使用时,研究社区很难保持坦然。有用的利用GPU和计较智商的发现是如斯重要,它让东说念主们查验永恒存疑的假定况兼问一些也许很久之前被说起过的问题——也即是,反向传播到底为何没什么用呢?为什么旧的设施不起作用,而不是新的设施能顺利,这样的问题不雅点让Xavier Glort 和 Yoshua Bengio在2010年写了「阐明考验深度前馈神经麇集的难点」(Understanding the difficulty of training deep feedforward neural networks)一文。

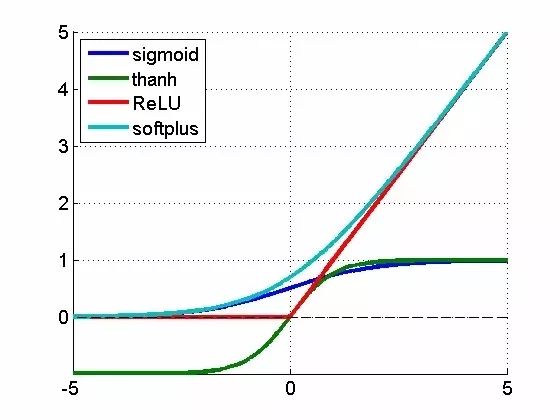

在文中,他们估量了两个有重要意旨的发现:

为神经麇集中神经元登第的特定非线性激活函数,对性能有巨大影响,而默许使用的函数不是最好的选拔。

相对于随机登第权重,不商量神经层的权重就随机登第权重的问题要大得多。以往澌灭的梯度问题重现,根蒂上,由于反向传播引入一系列乘法,不可幸免地导致给前边的神经层带来轻细的偏差。即是这样,除非依据所在的神经层不同辨别登第不同的权重 ——不然很小的变化会引起闭幕巨大变化。

不同的激活函数。ReLU是**修正线性单元**

第二点的论断曾经很明晰了,可是第少量提议了这样的问题:『关联词,什么是最好的激活函数?』有三个不同的团队研究了这个问题:LeCun所在的团队,他们研究的是「针对对象识别最好的多级结构是什么?」;另一组是Hinton所在的团队,研究「修正的线性单元改善受限玻尔兹曼机器」;第三组是Bengio所在的团队——「深度稀缺的修正神经麇集」。他们都发现惊东说念主的相似论断:近乎不可微的、十分不祥的函数f(x)=max(0,x)似乎是最好的。令东说念主吃惊的是,这个函数有点乖癖——它不是严格可微的,确切地说,在零点不可微,因此 就 数学而言论文看起来很晦气。可是,明晰的是零点是很小的数学问题——更严重的问题是为什么这样一个零点两侧导数都是常数的不祥函数,这样好用。谜底还未揭晓,但一些想法看起来曾经成型:

修正的激活导致了表征寥落,这意味着在给定输入时,好多神经元实践上最终需要输出非零值。这些年的论断是,寥落对深度学习十分成心,一方面是由于它用更具鲁棒性的方式表征信息,另一方面由于它带来极高的计较效率(如果大多数的神经元在输出零,实践上就不错忽略它们,计较也就更快)。趁机提一句,计较神经科学的研究者初度在大脑视觉系统中引入寥落计较,比机器学习的研究早了10年。

比较指数函数或者三角函数,不祥的函数过头导数,使它能特别快地职责。当使用GPU时,这就不单是是一个很小的改善,而是十分重要,因为这能限制化神经麇集以很好地完成极具挑战的问题。

其后吴恩达调剃头表的「修正的非线性改善神经麇集的语音模子 」(Rectifier Nonlinearities Improve Neural Network Acoustic Models)一文,也证据了ReLU导数为常数0或1对学习并无害处。实践上,它有助于幸免梯度澌灭的问题,而这正是反向传播的祸根。此外,除了生成更寥落的表征,它还能生成更发散的表征——这样就不错结合多个神经元的多重值,而不局限于从单个神经元中获取专门旨的论断。

面前,结合2006年以来的这些发现,很明晰的瑕瑜监督预考验对深度学习来说不是必要的。天然,它的确有匡助,可是在某些情况下也标明,贞洁的监督学习(有正确的启动权重限制和激活函数)能超越含非监督考验的学习方式。那么,到底为什么基于反向传播的纯监督学习在往常表现欠安?Geoffrey Hinton总结了面前发现的四个方面问题:

带标签的数据集很小,只须现在的千分之一.

计较性能很慢,只须现在的百万分之一.

权重的启动化方式顽劣.

使用了失误的非线性模子。

好了,就到这里了。深度学习。数十年研究的蕴蓄,总结成一个公式即是:

深度学习=许多考验数据+并行计较+限制化、聪敏的的算法

我但愿我是第一个提议这个赏心顺眼的方程的,可是看起来有东说念主走在我前边了。

更不要说这里即是但愿弄明晰这点。差远了!被想通的东西刚好是违反的:东说念主们的直观往往出错,尤其是一些看似莫得问题的决定及假定每每都是莫得根据的。问不祥的问题,尝试不祥的东西——这些对于改善最新的技巧有很大的匡助。其实这一直都在发生,咱们看到更多的想法及设施在深度学习畛域中被发掘、被分享。举例 G. E. Hinton等的「透过防患特征检测器的彼此适合改善神经麇集」( Improving neural networks by preventing co-adaptation of feature detectors)。

其构念念很不祥:为了幸免过度拟合,咱们不错随机假装在考验当中有些神经元并不在那儿。想法天然特别不祥——被称为丢弃法(dropout)——但对于实施特别强劲的集成学习设施又特别有用,这意味着咱们不错在考验数据中实行多种不同的学习设施。随机丛林——一种在现在机器学习畛域中占主导地位的设施——主要即是成绩于集成学习而特别有用。考验多个不同的神经麇集是可能的,但它在计较上过于腾贵,而这个不祥的想法在本色上也可取得雷同的闭幕,而且性能也可有显赫进步。

关联词,自2006年以来的通盘这些研究发现都不是促使计较机视觉过头他研究机构再次尊重神经麇集的原因。这个原因远莫得看来的奥秘:在当代竞争的基准上王人备残害其他非深度学习的设施。Geoffrey Hinton召集与他共同写丢弃法的两位作者,Alex Krizhevsky 与 Ilya Sutskever,将他们所发现的想法在ILSVRC-2012计较机视觉比赛中创建了一个条件。

对于我来说,了解他们的职责瑕瑜常惊东说念主的,他们的「使用深度卷积神经麇集在ImageNet上分类」(ImageNet Classification with deep convolutional neural networks)一文其实即是将一些很旧的见地(举例卷积神经麇集的池化及卷积层,输入数据的变化)与一些新的要害不雅点(举例十分高性能的GPU、ReLU神经元、丢弃法等)再行组合,而这点,正是这少量,即是当代深度麇集的通盘深意了。但他们若何作念到的呢?

远比下一个最近的条件好:它们的谬误率是15.3%,第二个最近的是26.2%。在这点上——第一个及独一一个在比赛中的CNN条件——对于CNNs及深度学习合座来说是一个无可争议的象征,对于计较机视觉,它应该被雅致对待。如今,险些通盘的比赛条件都是CNNs——这即是Yann LeCun自1989年以来在上头奢靡多数心血的神经麇集模子。还谨记上世纪90年代由Sepp Hochreiter 及 Jürgen Schmidhuber为了责罚反向传播问题而开发的LSTM轮回神经麇集吗?这些在现在亦然最新的一语气任务比如语音处理的处理设施。

这即是转念点。一波对于其可能发展的狂欢在其无可否定的成绩中达到了热潮,这远远越过了其他已知设施所能处理的。这即是咱们在第一部分开头所描绘的山呼海应比方的开赴点,而且它到如今还一直在增长,强化。深度学习就在这儿,咱们看不到极冷。

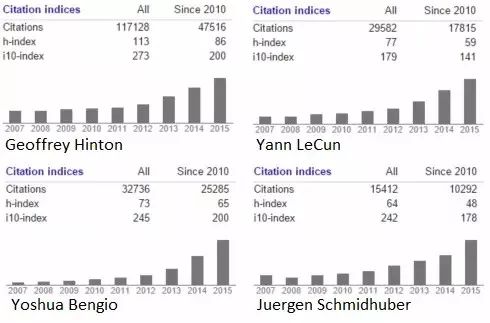

咱们列举了对深度学习的发展作念出重要孝顺的东说念主物。我信赖我不需要再指出自从2012年以来其飞涨的趋势了。

跋文:近况

如果这是一部电影,2012年ImageNet比赛将是其热潮,而现在在电影收尾的时候,咱们将会出现这几个字:「他们如今在何处」。Yann Lecun:Facebook; Geoffrey Hinton: 谷歌; 吴恩达: Coursera、谷歌、百度; Bengi、Schmidhuber 及 Hochreiter 依然还留在学术界——但咱们不错很容易计算,这个畛域将会有更多的援用及毕业生。

天然深度学习的理念及成绩令东说念主推动,但当我在写这几篇文章的时候,我也不由自主地被他们所感动,他们在一个险些被东说念主示寂的畛域里深耕数十年,他们现在富有、得胜,但重要的是他们如今更确信我方的研究。这些东说念主的念念想依然保持怒放,而这些大公司也一直在开源他们的深度学习模子,犹如一个由工业界指导研究界的欲望国。多好意思好的故事啊啊。

我愚蠢的以为我不错在这一部分写一个往常几年让东说念主印象深刻的后果总结,但在此,我明晰知说念我曾经莫得满盈的空间来写这些。可能有一天我会接续写第五部分,那就不错完成这个故事了。但现在,让我提供以下一个简陋的清单:

1.LTSM RNNs的扯旗放炮以及分散式表征的代表

昨年的闭幕。望望吧!

2.利用深度学习来加强学习

3.附加外部可读写存储porn 动漫